Réduire le temps entre information et action

Face aux nouveaux enjeux économiques, sociétaux, réglementaires et technologiques, les entreprises cherchent à optimiser le temps entre information et action. Mais, face à la multiplication des sources de données en variété, volumes et vélocité, aux scénarios d’interaction omni-canaux et d’intégration hybride, l’orchestration, la corrélation et la supervision des événements au cœur de l’exécution des processus métier est plus que jamais un véritable casse-tête.

Prendre en compte tous les événements qui circulent dans le système d’information, les réconcilier et les analyser pour prendre la bonne décision et réaliser la bonne action en temps réel est par nature complexe, mais incontournable pour l’entreprise digitale, notamment, mais pas uniquement, pour celles fortement impactées par l’Internet-of-Everything, la BlockChain et le Cloud Computing.

Migrer vers une architecture événementielle (Event Driven Architecture).

Evénement… vous avez dit événement ?

Un événement apporte un contexte à une donnée : sa raison d’être, sa date et son lieu d’apparition, son émetteur, sa nature…Il peut être de nature variée : technique (e.g. réception d’un fichier) ou métier (e.g. réception d’un bon de commande). Il est déclenché en lien à un changement qui peut être lui aussi de différentes natures (réalisation d’une transaction, franchissement d’un seuil, changement d’état…). Un événement est souvent la conséquence d’autres événements pouvant se produire de façon prévisible et ordonnée ou imprévisible et désordonnée.

Le Complex Event Processing (CEP) permet d’adresser cette complexité. L’événement n’est pas forcément complexe, ce qui l’est c’est avant tout sa gestion. Le CEP est à la fois un concept, une approche et des technologies pour effectuer en temps réel des traitements et des analyses avancées sur des flux d’événements bruts (on parle de stream events) ainsi que sur des nuages d’événements (on parle de cloud events) et corrélativement déclencher des nouveaux événements ou actions. Le CEP permet aussi de détecter des patterns complexes à partir de l’observation des événements, voire des anti-patterns à partir du comportement nominal.

Mais, malgré tout ce potentiel et si les cas d’usage candidats ne manquent pas, force est de constater qu’à aujourd’hui, les principales références entreprises sont dans le secteur financier, et souvent sur de la détection de fraude en temps réel ou sur de la supervision de processus.

Des cas d’usages boostés tout particulièrement par l’IOT

Dans le vaste champ d’application du CEP, nul doute que l’IoT qui vise à rendre, via l’utilisation massive de capteurs toutes choses inertes intelligentes et communicantes, et au-delà faire de toute personne un « objet connecté» soit le terreau et le catalyseur de démultiplication du CEP et ce dans tous les secteurs fortement consommateur d’IoT : la distribution pour l’optimisation de la chaîne d’approvisionnement, l’énergie pour l’optimisation des ressources, la construction pour la surveillance structurelle des bâtiments, l’assurance pour la prévention des risques…

Dans cette chaîne de valeur « IoT to Business Process », le CEP s’impose que le pivot essentiel pour corréler et orchestrer les flux et nuages d’événements issus des systèmes opérationnels (domaine des Operational Technologies) en amont des systèmes de gestion (domaine des Information Technologies).

Des nuages d’événements qui s’amplifient en regard de la complexification des processus d’entreprise. Ces derniers sont de plus en plus un mix complexe

- de scénarios d’interaction (Ubiquitous & Engaging User Experience),

- de processus collaboratifs repensés autour de registres distribués et de contrats intelligents s’exécutant de façon autonome (Blockchain & smart Contracts),

- de robots logiciels assurant la glue entre les processus linéaires et non-linéaires (Robotics Process Automation) ou prenant en charge directement les interactions humaines (Bot), les tâches répétitives (Robotics Desktop Automation)

- et enfin de systèmes, d’applications et de services hybrides on-premise/off-premise (Cloud computing).

Maîtriser leur exécution nécessite une approche à base d’événements, ne serait-ce que pour la supervision et la sécurité de l’ensemble.

Vers une plateforme d’événement intelligente

A la base, les technologies de CEP s’articulent autour d’un moteur de règles, exécutant des règles déterministes c’est-à-dire préalablement et parfaitement définies par les experts métiers selon une méthode dite de forward chaining : un événement complexe inféré est réinjecté pour déduire d’autres événements plus complexes.

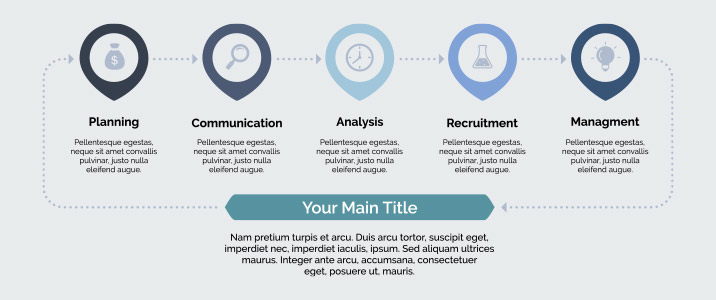

Face au nouveaux challenges de gestion des événements, les solutions historiques de CEP, qui ont peu évolué ces dernières années, de part le faible taux d’adoption en dehors de certaines niches d’usage, sont challengées. Les nouvelles exigences imposent une plateforme CEP augmentée autour de briques solutions intelligentes et élastiques sur les différents maillons de la chaîne de traitement des événements, rappelée ci-après (au périmètre du CEP) :

Ingestion des événements bruts provenant de différentes sources

Pre-processing des événements : application du fenêtrage (temporel ou selon le nombre d’événements) pour construire un contexte de traitement d’un sous-ensemble des événements ingérés en temps réel (Stream Processing). Une fois le contexte identifié, les événements peuvent être normalisés, enrichis ou filtrés et injectés in-Memory pour réaliser le Core Processing.

Core Processing de événements: analyse et pattern matching. Un moteur de règle est sollicité pour exécuter des règles métiers afin de détecter un pattern spécifique d’événements. Durant cette étape, les événements chauds et froids sont corrélés.

Post-processing des événements pour action: la détection d’un pattern déclenche une commande d’action. Cette action peut être matérialisée sous différentes formes et dirigées vers différentes natures de systèmes : une alerte à l’utilisateur, un ordre d’avancement d’un processus métier orchestré par un BPMS (Business Process Management System), une mise à jour d’un indicateur de pilotage porté par une solution de BAM (Business Activity Monitoring…), etc.

Les technologies CEP ne couvrent pas par nature la problématique de capture, ni de stockage des événements. Des maillons essentiels qui trouvent un atterrissage naturel respectivement dans les bus de données (data pipeliner, change data capture) et les lacs de données (data lakes), plus globalement dans les technologies Big Data : vélocité entre apparition des événements et mise à disposition pour traitement par le CEP, résilience si besoin de rejeu et élasticité en cas de pics d’événements by design, coût marginal de stockage réduit pour traçabilité et archivage des événements, capacité de traitement de masse économique, etc.

Surtout, les technologies CEP n’adressent pas l’imprévu alors que les situations non-déterministes vont se multiplier avec la complexité croissante de gestion des évènements. Et là, seules les technologies d’intelligence artificielle seront en mesure d’y faire face. Elles permettront notamment de générées des règles métiers automatiquement ou encore de prédire l’occurrence ou pas d’un événement.

Les plateformes de CEP nativement IA restent encore à inventer. Si certaines solutions historiques et plus récente (Open Source) permettent le débranchement vers des moteurs intelligents, la gestion complexe d’événement ne peut se réduire à une brique solution unique aujourd’hui. Il s’agit d’une solution composite à géométrie variable selon chaque contexte d’entreprise autour d’un triptyque CEP (historique) + AI (Machine Learning) + BIG DATA.

Titre pour SEO

Architecture

Banque

Stratégie d'évolution des systèmes de gestion d'actif documentaire

En savoir plus

Architecture

Banque

Qui te deseruisse contentiones, vis id wisi vocibus, nostro accusam officiis eos ea. Primis graecis rationibus duo no, propriae aliquando consequuntur ad qui.

En savoir plus

Architecture

Banque